Un nuevo estudio describe cómo logramos diferenciar la melodía y el lenguaje hablado. Los resultados podrían mejorar el funcionamiento de los implantes cocleares para la música.

El neurólogo argentino Robert Zatorre afirmó en una entrevista que la música es, junto al lenguaje, “una seña de identidad de todo ser humano”. Ambos son usos del sonido muy importantes y, según varios estudios de la última década, el cerebro procesa cada uno en un hemisferio.

Ahora, una investigación internacional liderada por el Instituto Neurológico de Montreal de la Universidad McGill (Canadá), donde ha participado Zatorre, revela por qué existe esta especialización. Los resultados se publican en la revista Science Advances.

“Hemos demostrado que la percepción del habla y de la melodía dependen de dos aspectos distintos de la acústica”, afirma a SINC el científico argentino.

Los investigadores crearon 100 grabaciones a capella con diferentes melodías y frases. Luego distorsionaron las grabaciones según dos dimensiones auditivas fundamentales: la dinámica espectral y la temporal, e hicieron que 49 participantes distinguieran en un experimento las palabras o las melodías de cada canción.

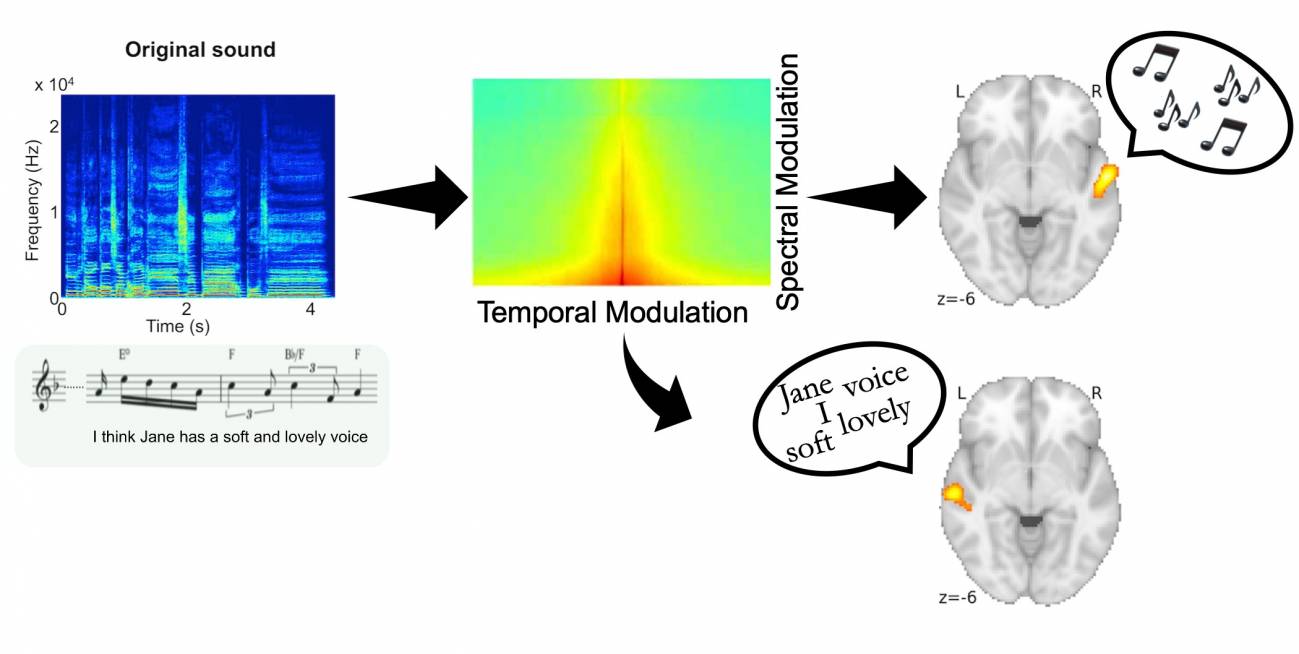

Los resultados mostraron que cuando la información temporal estaba distorsionada, las personas tenían problemas para distinguir el contenido del discurso, pero no la melodía. Por el contrario, cuando la dimensión espectral estaba deformada, tenían problemas para distinguir la melodía, pero no el habla.

“Nuestro estudio señala que las fluctuaciones temporales son muy importantes para comprender el habla, pero no la música, mientras que las fluctuaciones espectrales son imprescindibles para percibir las melodías, pero no el habla”, subraya Zatorre.

La canción original (abajo a la izquierda) y su espectrograma (arriba, en azul). La corteza auditiva de los lados derecho e izquierdo del cerebro decodifica la melodía y el habla, respectivamente, porque la melodía depende más de las modulaciones espectrales y el habla depende más de las modulaciones temporales. / Robert Zatorre

Para comprobar cómo responde el cerebro a estas diferentes características sonoras, se obtuvieron imágenes de resonancia magnética funcional (fMRI) de los participantes mientras distinguían los sonidos. Los investigadores descubrieron que el procesamiento del habla ocurría en la corteza auditiva izquierda, mientras que el procesamiento melódico ocurría en la corteza auditiva derecha.

“Precisamente, al tener dos zonas distintas, una en cada hemisferio, podemos procesar los dos tipos de índices acústicos de manera paralela y simultánea”, añade el neurólogo.

En estudios anteriores en animales se había probado que las neuronas de la corteza auditiva responden a combinaciones particulares de energía espectral y temporal, según los sonidos que son relevantes para el individuo en su entorno natural, como los sonidos de la comunicación. Para los humanos, tanto el habla como la música son medios de comunicación importantes.

"Estos resultados tienen aplicaciones interesantes, por ejemplo, en el área de los implantes cocleares. Por ahora, esos implantes funcionan bien para el habla, pero no la música. Nuestro trabajo ayuda a explicar por qué ocurre y quizás pueda mejorar su funcionamiento para la música”, concluye.

Referencia:

P. Albouy; L. Benjamin; R.J. Zatorre. “Distinct sensitivity to spectrotemporal modulation supports brain asymmetry for speech and melody”. Science Advances (27 de febrero de 2020). http://dx.doi.org/10.1126/science.aaz3468.