La computación cuántica se presenta como una de las tecnologías rompedoras para este siglo. Pero si generalmente todo lo relacionado con el mundo cuántico no es fácil de comprender, en este caso además los mensajes que circulan no ayudan a entender el alcance de esta tecnología y sus aplicaciones.

Entre las previsiones de las próximas revoluciones tecnológicas nunca falta la computación cuántica, un campo del que se esperan grandes beneficios. Según la visión del afamado físico y divulgador Michio Kaku en su libro de 2023 Quantum Supremacy - How the Quantum Computer Revolution Will Change Everything, esta tecnología encontrará las soluciones a todos los grandes problemas de nuestro tiempo. “Lo cambiará todo”, defiende Kaku.

La computación cuántica explota el extraño comportamiento del mundo subatómico, que aporta capacidades inalcanzables para los ordenadores actuales. La supremacía cuántica mencionada en el título de Kaku se refiere a la situación en la que uno de estos avanzados computadores sea capaz de resolver un problema que en la práctica resulte inabordable para la computación convencional.

Pero el hecho de que algunas de estas proclamas hayan sido cuestionadas por expertos es una muestra más de que en esta tecnología aún es mucho lo que falta por definir, comenzando por la propia frontera entre lo que logrará y lo que no, entre realidad y ficción. ¿Está justificado el tecnooptimismo de Kaku? ¿Qué es la computación cuántica y qué podemos esperar realmente de ella?

La computación que conocemos se basa en una unidad mínima de información llamada dígito binario o bit, que puede adoptar uno de dos valores representados habitualmente como 0 o 1.

Frente a esto, el bit cuántico o cúbit aprovecha las insólitas reglas del mundo cuántico: así como el famoso gato de Schrödinger está vivo y muerto al mismo tiempo, un cúbit admite una combinación probabilística de múltiples estados a la vez, una propiedad conocida como superposición.

De este modo, el cúbit puede almacenar más información que un bit clásico. Además, distintos cúbits trabajan conjuntamente comunicándose a través del llamado entrelazamiento cuántico, lo que aumenta la capacidad de procesamiento con respecto a la computación tradicional.

El bit y el cúbit son conceptos que en la práctica deben materializarse en un soporte físico. El primero lo encontró en el transistor de silicio, un material semiconductor con dos estados posibles. Los transistores, hoy del tamaño de nanómetros, se agrupan en los circuitos integrados o chips que forman los microprocesadores; los actuales llegan a acumular cientos de miles de millones de transistores, en algunos casos incluso billones en un solo procesador.

Los cúbits aún se encuentran en un estado mucho más primitivo. Por el momento no existe un estándar universal; diversas tecnologías compiten para demostrar sus ventajas utilizando luz, iones o campos magnéticos. Muchos de los sistemas existentes hoy se basan en el uso de circuitos superconductores o iones atrapados, pero los expertos auguran oportunidades para ciertas tecnologías emergentes.

Entre estas destaca —no sin controversia— la que se basa en un tipo de partículas elementales llamadas fermiones de Majorana y que Microsoft ha aplicado a la creación de un nuevo chip. Además, los investigadores exploran las ventajas que pueden ofrecer las peculiares propiedades de materiales especiales como las tierras raras.

Aún no hay medidas estandarizadas del rendimiento de la computación cuántica, lo que dificulta la comparación de tecnologías distintas; por ejemplo, algunas funcionan a temperatura ambiente, mientras que otras requieren frío cercano al cero absoluto, -273 grados centígrados. Tampoco pueden compararse los sistemas por su número de cúbits.

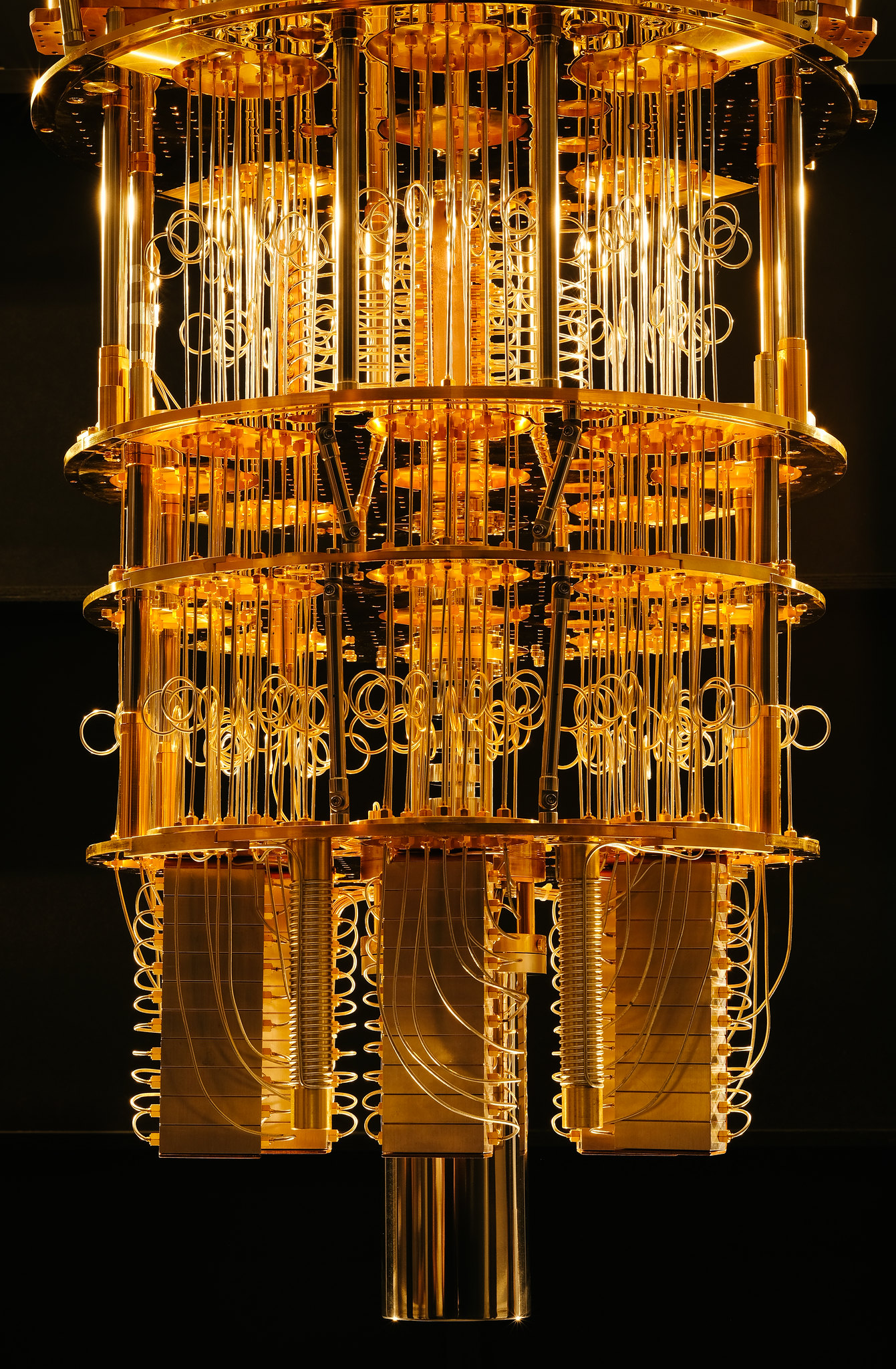

Un criostato de la compañía IBM. Se trata de un dispositivo utilizado para mantener los componentes de un ordenador cuántico a una temperatura cercana al cero absoluto. / IBM

La computación cuántica no ha despegado porque aún deben superarse grandes desafíos técnicos. Para empezar, su funcionamiento depende de que la magia del comportamiento cuántico se mantenga el mayor tiempo posible. Pero las interferencias, el ruido y la interacción de los cúbits con su entorno provocan decoherencia, una pérdida de los estados cuánticos de superposición y entrelazamiento.

Para evitar esta pérdida de información, una buena cantidad de cúbits se dedican a corrección de errores. Un modo de construir sistemas más robustos es distribuir la información entre un grupo de hasta un millar de cúbits físicos redundantes, que forman así un “cúbit lógico”. El resultado es una mayor fiabilidad, pero a costa de sacrificar potencia.

Esto obstaculiza también la escalabilidad de los ordenadores cuánticos. Actualmente los más grandes se sitúan en el orden del millar de cúbits, pero en el futuro deberían saltar hasta una escala de millones. Y cuantos más cúbits, más frágil es la coherencia cuántica.

A todos los retos técnicos que aún deben superarse se añaden los necesarios desarrollos y estandarizaciones de hardware y software para que la computación cuántica pueda llegar algún día a una fase comercial. Algún investigador en este campo ha comparado el estado actual a lo que era la computación clásica a finales de los años 80.

En la arena de la computación cuántica compiten gigantes tecnológicos como IBM, Google o Intel, junto con centenares de startups y entidades académicas asociadas.

En noviembre de 2024 IBM presentó su sistema más avanzado hasta la fecha, Heron R2, con 156 cúbits. Es el más rápido de la compañía, pero no el más potente: Condor, lanzado un año antes, es el segundo procesador cuántico más grande hasta hoy, con 1 121 cúbit, solo por debajo del sistema de 1180 cúbits creado por la californiana Atom Computing. Por su parte, Google presentó en diciembre de 2024 su último modelo, Willow, con 105 cúbits.

La compañía D-Wave Quantum fabrica procesadores que ya superan los 7 000 cúbits, pero utiliza un tipo de tecnología específica para problemas de optimización, llamada annealer,menos versátil para un uso en computación general.

Diversos sistemas están accesibles en la nube para los usuarios, lo que no solo presta servicios a instituciones de investigación, sino que además contribuye al propio desarrollo de la computación cuántica mediante las aportaciones de nuevos algoritmos.

Algunas fuentes expertas han sugerido que 2025 podría marcar un salto en el escalado de chips cuánticos hacia los cientos de miles de cúbits físicos, lo que depende también de una mayor miniaturización.

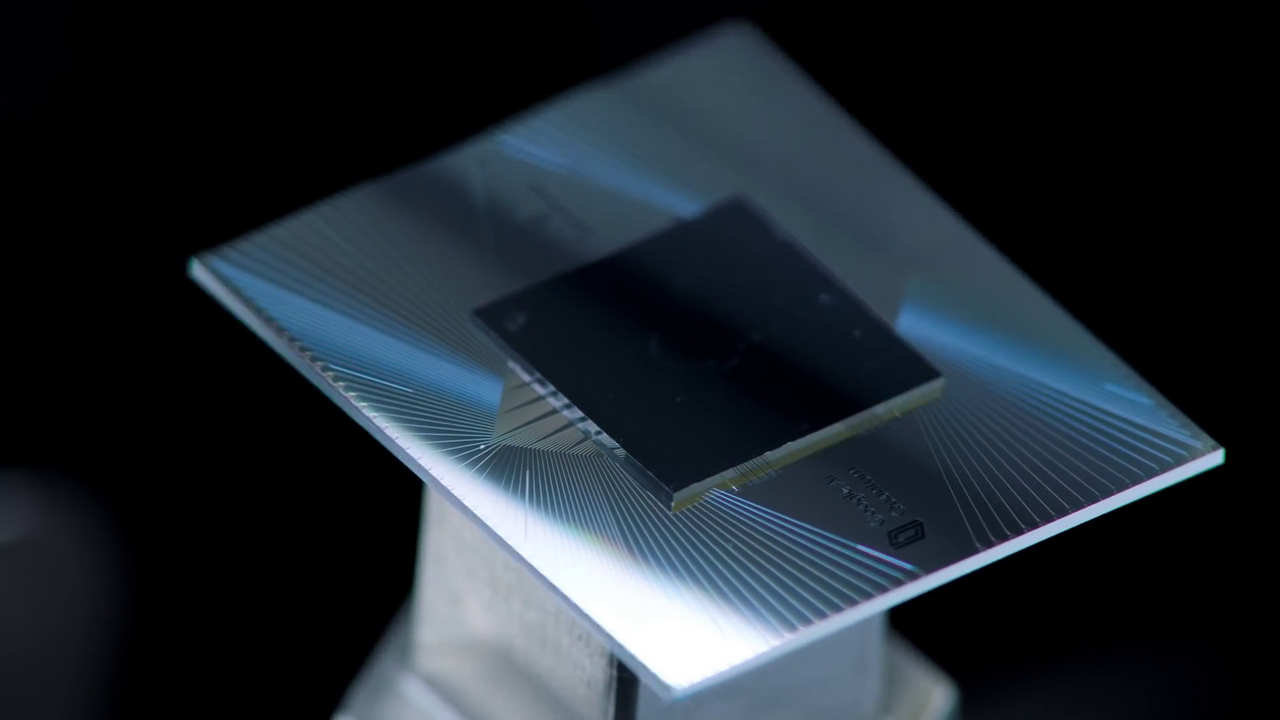

El procesador cuántico Sycamore de Google. / Google / Wikimedia Commons

Un artículo publicado en Nature en 2023 se preguntaba para qué eran útiles los ordenadores cuánticos. La respuesta: “Por ahora, absolutamente para nada”. Pero lo serán: los comentarios suelen coincidir en que la computación cuántica será provechosa en la simulación de sistemas físicos y químicos o la criptografía, si bien aclaran que el beneficio no será tanto el abordaje de problemas antes irresolubles, sino una reducción del tiempo de procesamiento.

El problema con otros usos, señalan investigadores y expertos, es que la computación cuántica no aportará mejoras sustanciales respecto a la clásica, ni siquiera en el tiempo. Por ello y según contaba a Nature el científico computacional de la Universidad de Texas Scott Aaronson, “todos los demás casos de usos de los que la gente habla son más marginales, más especulativos, o ambas cosas”. Aaronson ha sido demoledor con el libro de Michio Kaku, que ha calificado como “el peor libro sobre computación cuántica” y un cúmulo de mentiras.

Así, frente a quienes vaticinan un futuro de computadores cuánticos para todo y para todos, una visión más prudente sostiene que se restringirán a usos especializados y no reemplazarán a la computación clásica, sino que la complementarán, lo que exigirá un desarrollo de la comunicación entre ambos tipos de sistemas.

Observadores del sector han apuntado que en los últimos años, ante las dudas sobre las expectativas de la computación cuántica y el bombo en torno a los sistemas de inteligencia artificial basados en modelos grandes de lenguaje, como ChatGPT, un notable volumen de inversiones y del interés de las compañías financieras se ha desplazado del primer campo al segundo.

También llamada ventaja cuántica para evitar las connotaciones negativas de la palabra ‘supremacía’, es una meta planteada desde las primeras propuestas de este tipo de computación. Este hito se alcanza cuando un ordenador cuántico es capaz de resolver un problema que ningún computador clásico pueda solucionar en un periodo de tiempo aceptable, pero no tiene por qué tratarse de un problema útil ni práctico.

En 2019 Google anunció que su ordenador Sycamore, con un chip de 54 cúbits, había resuelto en 200 segundos una serie de operaciones que un supercomputador clásico equivalente a unos 100 000 ordenadores normales tardaría 10 000 años en completar. Sin embargo, IBM objetó la estimación de su rival, afirmando que la tarea podía realizarse en solo 2,5 días en un ordenador tradicional.

Después han surgido otras proclamas de supremacía o ventaja, pero habitualmente la revisión de los algoritmos aplicados para resolver el problema mediante la computación clásica ha rebajado sustancialmente la diferencia del tiempo de procesamiento entre ambos tipos de sistemas. De cualquier manera, los científicos señalan que estos avances son valiosos como hitos científicos, sin impacto en el progreso comercial de la computación cuántica.